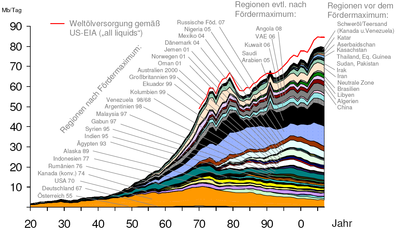

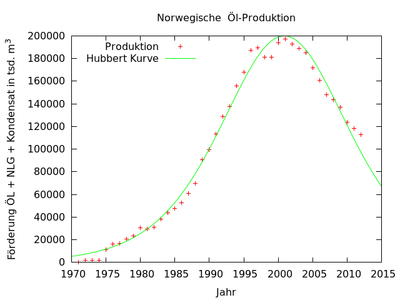

Eine genaue Vorhersage des Ölfördermaximums ist aufgrund der Unvorhersehbarkeit der Ölfunde nicht möglich. Erst wenn wie am Beispiel Norwegens das Maximum signifikant überschritten wurde, wird der Verlauf der zukünftigen Ölförderung berechnet werden können nach dem Modell Hubberts. Die Kurve der Funde von Öllagerstätten zeigt bereits, daß der Zenit überschritten wurde und es immer schwerer wird, neue Lagerstätten zu entdecken.

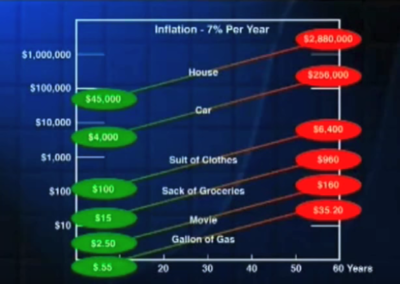

Der durchschnittliche menschliche Verstand ist unfähig, das exponentielle Wachstum in seinen Konsequenzen zu erfassen. Exponentielles Wachstum kann mit Hilfe der Verdopplungszeit leichter im Kopf berechnet werden. Dabei gilt: Bei jeder neuen Verdopplung ist die Fläche unter der Kurve im letzten Verdopplungsabschnitt größer als die Fläche aller vorherigen Verdopplungen zusammen. Zeigt die Kurve des Ölverbrauchs ein rein exponentielles Wachstum, so wurde innerhalb der letzten Verdopplung des Verbrauches mehr Öl umgesetzt als in der gesamten vorherigen Geschichte der Ölnutzung. Für die Zukunft bedeutet das, daß mit der nächsten Verdopplung mehr Öl gefunden werden muß, als die Menschheit bis dahin verbraucht hat.

Stetiges Wachstum ist eine andere Form für die Darstellung exponentiellen Wachstums. Es kann vereinfacht mit der 70ger-Regel beschrieben werden:

70/Wachstum in Prozent pro Zeit = Verdopplungszeit

(genauer: ln(2)*100%/(%-Wachstum/Zeit)=Verdopplungszeit )

Beispiel: Bis 1970 wuchs der Ölverbrauch in den USA um „stabile“ 7% pro Jahr, d.h., alle 10 Jahre verdoppelte sich der Ölverbrauch. Bei 2%/Jahr ist die Verdopplungszeit 35 Jahre. Mit nur 10 Verdopplung vertausendfacht sich nahezu der ursprüngliche Wert. Dies führt unweigerlich in die exponentielle Katastrophe, wenn eine endliche Ressource gegen einen exponentielle wachsenden Verbrauch ausgebeutet wird. Ewiges Wachstum kann es daher nicht geben. Es wird unweigerlich zum Rückgang des Wachstums führen oder gar zu negativem Wachstum, wenn die Ressource versiegt. Viele Vorhersagen berücksichtigen nicht das exponentielle Wachstum des Verbrauchs, sondern sie ziehen immer nur den aktuellen Verbrauch in den Vergleich ein. Dadurch wird eine erheblich längere Versorgungsicherheit suggeriert als real vorhanden ist.

In der Konsequenz bedeutet Nachhaltigkeit 0% Wachstum einer nicht endlichen Ressource oder einer Ressource, die für Millionen von Jahren die Versorgung sicherstellt.

Das Beispiel mit dem Schachbrett verdeutlicht das Problem mit dem Verständnis der exponentiellen Funktion: Der Kaiser gewährte seinem Diener einen Wunsch. Der Diener sagte: „Meine Wunsch ist moderat: Lege auf das erste Feld im Schachbrett ein Getreidekorn, auf das zweite doppelt so viel wie auf dem ersten, auf dem dritten doppelt so viel wie auf dem zweiten und so fort.“ Um wieviel Getreide handelt es sich? Mathematisch ergibt sich die Zahl zu 264-1. Das ist etwa die 424-fache weltweite Getreideernte von 2019.

Vortrag:

Prof. Al

Bartlett: Arithmetic, Population and Energy <---- sehr

empfehlenswert!

Bildquelle: Aus dem Vortrag.

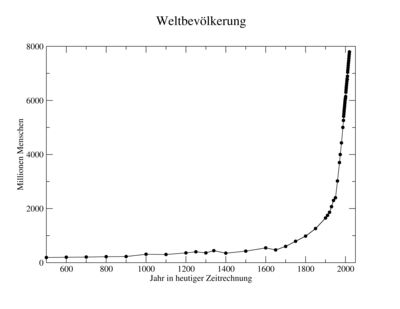

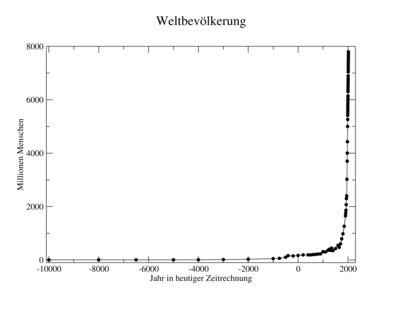

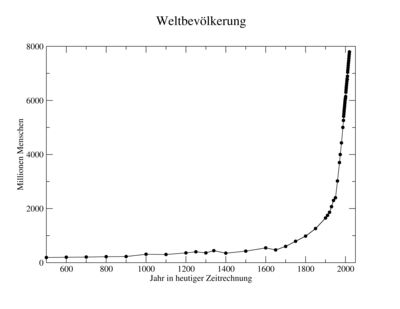

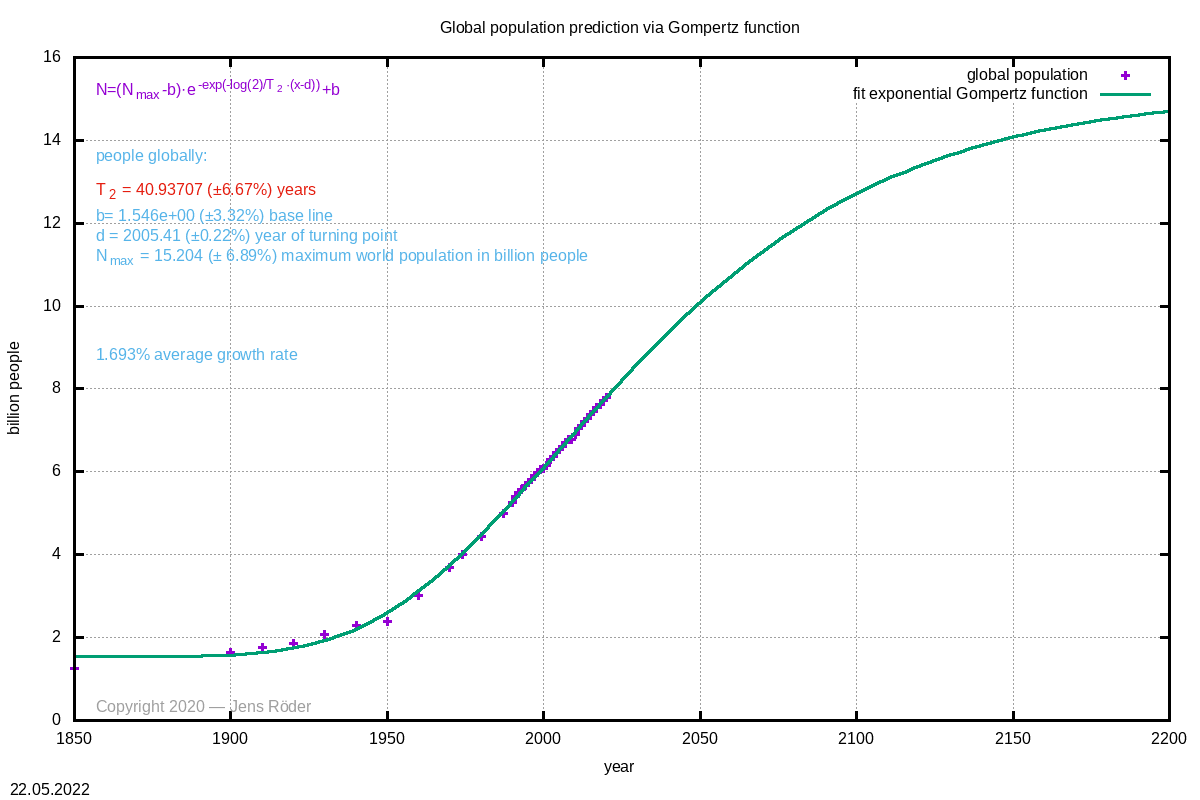

936 AD betrug die Weltbevölkerung rund 250 Millionen und

verdoppelte sich erst 1567 AD nach 631 Jahren auf 500

Millionen. In diesem Zeitraum betrug die Wachstumsrate der

Menschheit 0,11%. Das Wachstum war über lange Zeiträume sehr

gering. Die erste Milliarde wurde dann etwa 1803 AD nach

weiteren 236 Jahren erreicht. In diesem Zeitraum betrug die

Wachstumsrate etwa 0,29%. Mit der einsetzenden industriellen

Revolution verbesserten sich die Lebensbedingungen der

Menschen. 1926 wuchst die Menschheit nach nur 123 Jahren auf 2

Milliarden mit einer Wachstumsrate von 0,56%. Nach nur 48

Jahren verdoppelte sich die Menschheit auf 4 Milliarden mit

einer Wachstumsrate von 1,44%. Die hohen Verluste der zwei

Weltkriege (etwa 60 Millionen Tote) und die Folgen des

Kommunismus (ca. 100 Millionen Tote) hatten wenig Auswirkung

auf das Wachstum. Die 8. Milliarde wird um 2023 AD nach nur 49

Jahren zu erwarten sein. Dabei ist die Wachstumsrate mit 1,42%

unwesentlich kleiner. Die Abbildungen a.) und b.)

veranschaulichen diese Entwicklung.

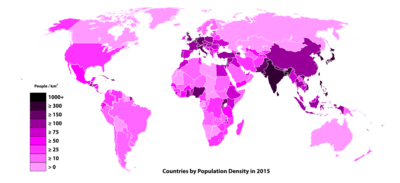

In China und Indien wohnen heute ca. 40% der Weltbevölkerung. In Abbildung c.) wird deutlich, daß in den Ländern Indien, Bangladesh, Nigeria und Deutschland die höchsten Bevölkerungsdichten zu finden sind. Die Vorhersagen der UN nehmen an, daß das Wachstum der Menschheit bei 10 Milliarden sein Maximum erreichen würde. Solange jedoch die Nahrungsmittelindustrie die Menschen ausreichend mit Nahrung versorgen wird, gibt es keinen äußeren Zwang, und die Menschheit wird sich weiter vermehren. Die nächsten Jahrzehnte werden zeigen, ob die Menschheit nicht doch auf 15 Milliarden anwachsen wird. Politisch wird das Problem des Bevölkerungswachstums vermieden, und nur China hatte zeitweise den Ansatz, sein Bevölkerungswachstum zu reduzieren. Dabei war jedoch das Ziel, die wirtschaftliche Entwicklung zu schaffen. Millionen neuer Menschen pro Jahr erfordern den jährlichen Bau ganzer Großestädte nebst Infrastruktur, weshalb viele Ressourcen, die für die Industrialisierung notwendig sind, in dem Bau der Städte gebunden sind.

Eine kleine Rechnung am Beispiel Ägyptens, das eine Wachstumsrate von 2% hat, soll das Problem deutlicher aufzeigen: Nach der 70ger-Regel verdoppelt sich bei stetigem Wachstum die Bevölkerung des Landes nach 35 Jahren. Nach 70 Jahren, die Lebenszeit eines Menschen, hat sie sich vervierfacht. Heute sind es 100 Millionen Ägypter, in 35 Jahren sind es 200 Millionen und in 70 Jahren 400 Millionen. Das sind mehr Menschen als es heute US-Amerikaner gibt. 1950 waren gab es nur 12 Millionen Ägypter; die Bevölkerung hat sich bis heute mehr als verachtfacht. Diese Anzahl Menschen kann das Land am Nil schon lange nicht mehr ernähren, so daß Ägypten von Weizenimporten heute abhängig ist. Aktuell muß Ägypten für jedes Jahr eine Großstadt für 2 Millionen Menschen bauen in die alle Ressourcen fließen. Dabei wachsen die Städte gerade in das so benötigte Ackerland. Während des arabischen Frühlings wurde aufgrund der Revolution der Bau neuer Kraftwerke eingestellt. Die Folge waren jahrelange Stromausfälle, weil das Land einen Bedarf von 26 GW hatte, jedoch nur 20 GW installiert waren. Ob in Ägypten wirklich 400 Millionen Menschen leben und ernährt werden können, wird fraglich sein, wenn nicht grundlegend neue Entdeckungen gemacht werden, die das ermöglichen. In wieweit eine so große Bevölkerung sinnvoll ist und ob eine so hohe Bevölkerungsdichte eine Lebensqualität bieten kann, ist eine gesamtgesellschaftlich-philosophische Frage, die die Ägypter sich stellen müssen, ob und wie sie das lösen wollen oder ob sie der Natur die Regelung überlassen werden, mit all ihren auch unmenschlichen Folgen.

Für die Umwelt und das biologische Gleichgewicht wird eine so hohe Bevölkerungsdichte der Erde dramatische Folgen haben. Schon jetzt erleben wir ein Artensterben, wie es seit dem Ende der Dinosaurier nicht wieder vorgekommen ist. In Abbildung e.) ist das Biomassenverhältnis von Säugetieren aufgezeigt. Nur noch 4% der Säugetierbiomasse fällt auf die Wildtiere, 36% dieser Biomasse macht der Mensch aus und 60% sein Vieh. Ein solches Ungleichgewicht kann für die Natur nicht ohne Folgen bleiben, auch wenn wir meinen, diese Bevölkerungsdichte technologisch beherrschen zu können.

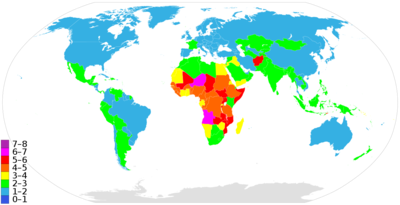

Während in den Industrienationen die Bevölkerung leicht zurückgeht, wächst sie besonders stark im afrikanischen Kontinent, vergleiche Abbildung f.). Die Politik und die Wirtschaft fürchten einen Rückgang der Bevölkerung, weil die Wirtschaft mit weniger Arbeitskräften schrumpft und der Politik das Geld fehlt. Die Verantwortlichen erkennen nicht, daß ein sehr langsamer Bevölkerungsrückgang sogar etwas Gutes ist und zum Regelmechanismus der Natur gehört, ohne landesgefährdend zu sein. In der Nähe des Gleichgewichts kommt es immer zu einem leichten Pendeln der Bevölkerungsdichte, wie wir es aus anderen Populationen von Tieren beim Studium ihrer Biologie her bestens kennen. Wir wenden diese Erkenntnis jedoch nicht auf uns selbst an. In 2015 kam es in Deutschland kurzzeitig zu einem Bevölkerungsrückgang von nur 0,5%, woraufhin die Politik Alarm schlug. Ab 2015 bis 2020 stieg die Bevölkerungsdichte aufgrund von Zuzug von 226 Menschen/km² auf 232 Menschen/km², also um Rund 2 Millionen Menschen. Das entspricht der Städte Hamburg und Braunschweig zusammen!

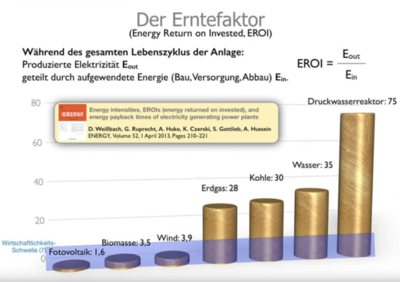

Die Nahrungsmittelproduktion ist heute unweigerlich an die Ölproduktion gekoppelt. Die hohe Energiedichte von Erdöl ist ca. 11 kWh/L. Ein Mensch hat einen Energieumsatz von 90-100 Watt, d.h., er muß 11 Stunden arbeiten, um auf das Energieäquivalent zu kommen. Eine Pferdestärke entspricht 736 Watt. Ein Pferd leistet damit soviel wie etwa 7 Menschen. Traktoren haben Leistungen um die 100 kW. Die Folge der Motorentwicklung war, daß heute 1-2 Menschen die Arbeit auf einem Bauernhof schaffen können, für die früher 30-40 Menschen auf den Feldern nötig waren. Ohne diese Energiequelle ist mit Einbußen in der Ernte zu rechnen, die die Nahrungsmittelversorgung der Menschheit gefährden kann. Wie aus den obigen Abbildungen ersichtlich wird, zeichnet sich das Ende der Erdölzeit ab. Wie weiter unten deutlich wird, haben die erneuerbaren Energien zu niedrige Erntefaktoren, um wirtschaftlich zu sein, weil sie nur unwesentlich mehr Energie liefern, als für ihre Produktion benötigt wird.

Der Klimawandel ist nicht die größte Gefahr für die Menschheit, sondern ihr exponentielles Wachstum gegen eine endliche, essenzielle Ressource.

Berechnung nach Gompertz Funktion.

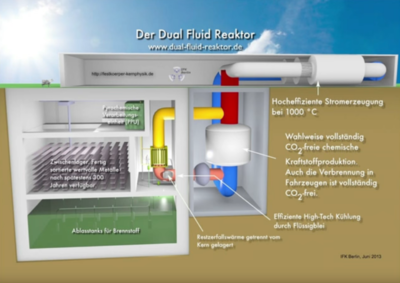

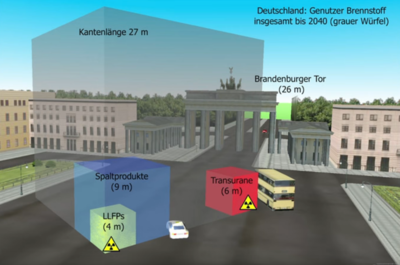

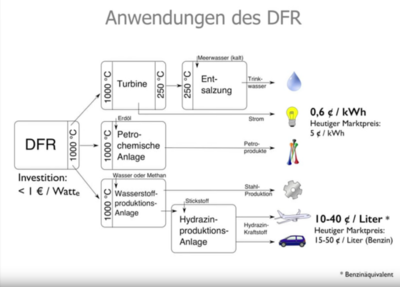

Der Erntefaktor beschreibt das Verhältnis der für eine Anlage aufgewendeten Energie und die aus ihr erzeugte Energie. Der Erntefaktor von Photovoltaik, Biomasse und Wind liegt unterhalb der Wirtschaftlichkeitsgrenze. Entsprechend ist damit zu rechnen, daß der Lebensstandard sinkt und die Bevölkerung verarmt. Mit dem neuen Dual-Fluid-Reaktor kann ein sehr hoher Erntefaktor erreicht werden. Herkömmliche Kernkraftwerke haben einen Erntefaktor, der unwesentlich besser ist als der von Kohlekraftwerken, was an der weniger effizienten Methode der Wasserdampftechnik liegt. Der neue Dual-Fluid-Reaktor verwendet Salz- und Metallschmelzen, die einen viel besseren Wärmetransport ermöglichen. Er arbeitet bei sehr geringen Drücken und ist physikalisch passiv sicher, d.h. er kann im Störfall nicht explodieren wie die Leichtwasserkernkraftwerke. Radioaktive Abfälle müssen nur 100-300 Jahre gelagert werden und sind anschließend wertvolle Rohstoffe. Sie werden durch Destillation aus dem Prozeß entfernt. Eine aufwendige Aufbereitung mit zusätzlichen Abfällen aus dem chemischen Prozeß entfällt vollständig. Langlebige radioaktive Abfälle aus alten Leichtwasserreaktoren können als wertvolle Rohstoffe zu kurzlebigen radioaktiven Abfallstoffen verbrannt werden. Die bestehenden radioaktiven Abfälle Deutschlands könnten die Energieversorgung des Landes für 2000 Jahre sicher stellen, mit Berücksichtung der Kraftstofferzeugung für 700 Jahre. Während Leichtwasserreaktoren nur ca 1% des angereicherten Urans (Uran-235 Anreicherung) verbrennen, kann der Dual-Fluid-Reaktor auch das Uran-238 voll nutzen. Zudem kann der Dual-Fluid-Reaktor auch Thorium verwenden, das viel häufiger vorkommt als Uran ist. Geht man von einer Bevölkerungszahl von 10 Milliarden aus, dann könnte die Energieversorgung der Menschheit für 1 Milliarde sichergestellt werden, wenn man von einer Leistung 100 Terrawatt ausgeht. Damit wäre ein sehr effizientes und nachhaltiges Verfahren gegeben. Hierfür muß man von einer Entwicklungszeit von 10-15 Jahren ausgehen. Die dann anfallenden Baukosten für das Kraftwerk wären mit denen eines Kohlekraftwerks vergleichbar.

Vortrag:

Dr. Armin

Huke: Der Dual Fluid Reactor – die zukünftige “alternative”

Energieerzeugung?

(CEO

am Institut für Festkörperphysik)

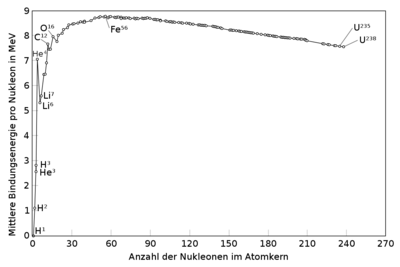

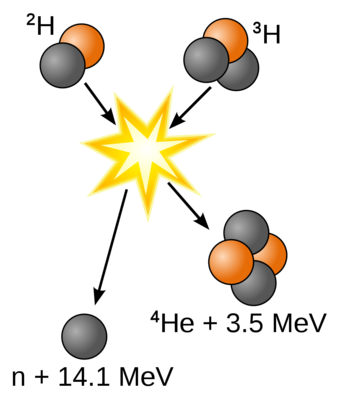

Die Bindungsenergie von Nukleonen (Protonen, Neutronen) ist um viele Größenordnungen höher als die chemischer Bindungen. Die erste Graphik zeit das Verhältnis der Bindungsenergie pro Nukleon. Das stabilste Element ist Eisen, aus dem durch Spaltung oder Fusion keine Energie mehr gewonnen werden kann. Die größte Differenz ist zu sehen beim Verschmelzen von Wasserstoff zu Helium. Aus diesem Grunde hat die Kernfusion hat ein großes Zukunftspotential, weil die Rohstoffe, Wasserstoff, Deuterium und Lithium sehr häufige Elemente auf der Erde sind und eine große Energiemenge aus ihrer Verschmelzung gewonnen werden kann. Zudem haben die Abfallstoffe im Prozeß, die radioaktiv dabei werden, meist eine nicht zu lange Halbwertszeit, die vergleichbar ist mit dem Dual-Fluid-Reaktor.

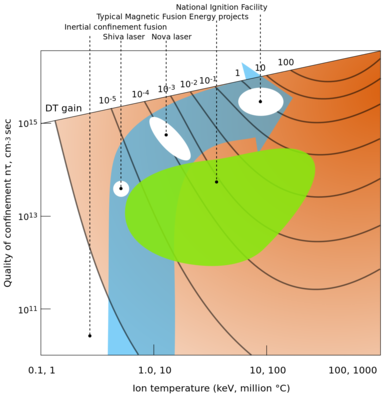

Die Bedinungen für die Fusion sind sehr extrem. Man benötigt sehr hohe Temperaturen um 200 Millionen °C, damit die Teilchen eine so hohe kinetische Energie haben, damit sie die elektrischen Abstoßungskräfte überwinden können und die Kernkräft, die nur eine kurze Reichweite hat, groß genug werden, um die Kerne zu verschmelzen. Deuterium und Tritium, je Isotope des Wasserstoffs, liegen bei den Temperaturen als Plasma vor. Im Plasma haben die Atome ein oder mehre Elektronen abgegeben und sie liegen als geladene Teilchen (Ionen) neben den freien Elektronen vor. Ein Plasma ist daher elektrisch leitend und wird auch als 4. Phasenzustand bezeichnet (fest, flüssig, gasförmig, plasmaförmig). Weil das Plasma elektrisch leitend ist, kann es magnetisch eingeschlossen werden. Der Einschluß ist notwendig, um das sehr heiße Plasma von den kalten Wänden der Reaktorkammer fern zu halten, damit das Plasma seine Wärmeenergie nicht verliert. Hat das Plasma die richtige Temperatur und den richtigen Druck erreicht, kann es sich selbst erhalten aus der freiwerdenden Fusionsenergie. Bisher werden die Bedingungen für ein ausreichend lange selbstbrennendes Plasma noch nicht erreicht. Die Ursachen liegen bisher an Plasmafluktuationen, also Verwirbelungen im Plasma, die einen erhöhten Wärmeverlust an den Wänden verursachen. Dieses Problem kann erst mit sehr großen Brennkammern überwunden werden, die größer als 12 Meter im Durchmesser sind. Das Projekt ITER in Frankreich hat als erste Pilotanlage zum Ziel, das längere Eigenbrennen von Plasma nachzuweisen. Der geplante Erntefaktor soll um 10 liegen und liegt gegenüber einem Dual-Fluid-Reaktor noch weit zurück. Hat ITER Erfolg, kann ein erster Produktionstestreaktor gebaut werden. Diese Energiequelle wird frühstens in 30-40 Jahren verfügbar werden.

Die Ölvorräte bei der aktuell wachsenden Bevölkerung werden bis dahin nicht ausreichen und Übergangslösungen oder Alternativen werden notwendig sein.

Ein Einführungsvortrag: Prof. Hartmut Zohm: Kernfusionsforschung

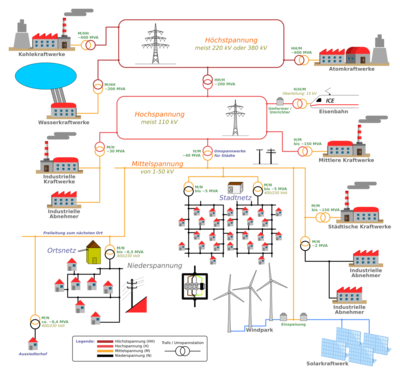

In unserem Stromnetz wird ständig ein Gleichgewicht gehalten zwischen produzierter Energie und ihrem Verbrauch. In jedem Moment muß genausoviel Strom produziert werden wie verbraucht wird, sonst bricht das Stromnetz zusammen. Das Netz muß also ständig nachgeregelt werden. Kurzzeitige Leistungsschwankungen werden durch die Primärregelung aufgefangen. Sie besteht aus der Rotationsenergie aller laufenden Generatoren.

Wird mehr Energie entnommen, als gerade erzeugt wird, so kommt die Energie, bis die Energieproduktion nachregelt, aus der Rotationsenergie. Dadurch sinkt die Netzfrequenz. Diese ist daher die Meßgröße, mit der das Netz geregelt wird. Sinkt die Netzfrequenz, regeln die Kraftwerke durch Erhöhung der Energieproduktion nach. Reicht dies nicht aus, müssen weitere Kraftwerke zugeschaltet werden. Diese Regelungen heißen Sekundär- und Minutenreserve und sind im allgemeinen sehr teuer, weil die Kraftwerksbereitstellung kostenintensiv ist. Im allgmeinen ist der Verlauf des Verbrauchst am Tage gut bekannt und kann daher gut im Voraus geplant werden.

Schwierig wird es, wenn keine weitere Kraftwerksleistung mehr zur Verfügung steht. Um den Zusammenbruch des Netzes dann zu vermeiden, werden Verbraucher vom Netz abgeworfen und sie erleben einen Stromausfall. Die rechte Abbildung zeigt den bisher größten europäischen Stromausfall am 4. November 2006. Deutlich ist der rasante Abfall der Netzfrequenz zu beobachten, worauf es zu flächendeckenden Ausfällen durch Lastabwurf kam. Ohne Lastabwurf würde letztlich das ganze Netz zusammenbrechen. Ein Neustart ist dabei viel aufwendiger.

Fallen überraschend große Verbraucher aus, so steigt

die Netzfrequenz und die Spannung. In diesem Fall müssen

Kraftwerke herunterregeln oder vom Netz genommen werden.

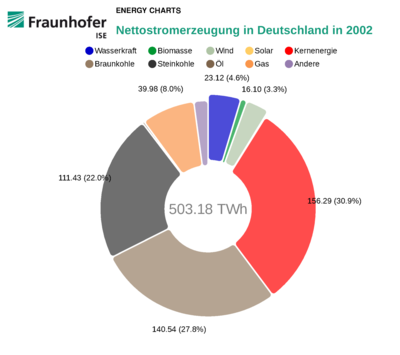

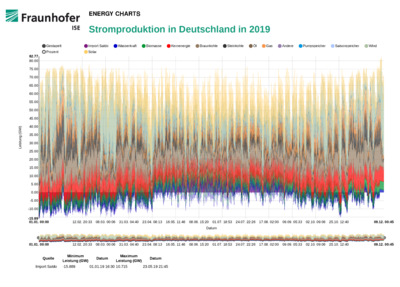

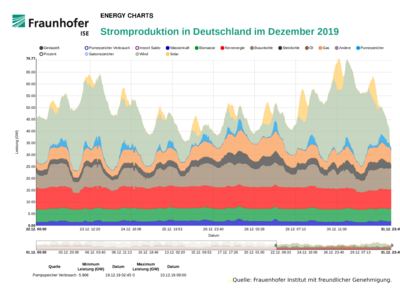

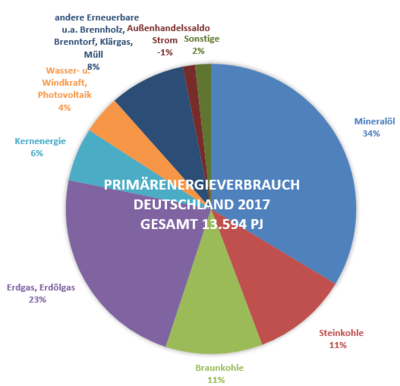

Beide Abbildungen des Frauenhofer Instituts verdeutlichen den schnellen Umbau der deutschen Stromproduktion. Dieser Umbau hat dazu geführt, daß die Strompreis um 8¢/kWh auf 30¢/kWh gestiegen sind und zu den höchsten Europas zählen. Zum Vergleich liegt der Strompreis in Frankreich bei 18¢/kWh und in Ungarn bei nur 11¢/kWh. Hätte Deutschland seine seine Kernkraftwerke, die mit zu den sichersten der Welt zählen, beibehalten, könnte inzwischen komplett auf die Verbrennung von Braunkohle verzichtet werden und ein Teil der Kostensteigerung vermieden werden. Mit der Entwicklung moderner Dual-Fluid-Reaktoren könnte der Stromreis um Faktor 26 sinken und dabei der langlebige radioaktive Abfall der alten Kernkraftwerke in kurzlebigen Abfall umgewandelt werden, so daß er nur noch 100-300 Jahre gelagert werden müßte und keine so große Gefahr für die zukünftige Umwelt mehr darstellt. Zusätzlich wären diese Anlagen inherent sicher, d.h., sie können nicht wie die bisherigen Reaktoren explodieren. Langfristig betrachtet, ist der Ausstieg aus der alten Kerntechnik sogar sinnvoll, die Aufgabe der Kernkraftwerkstechnologie jedoch nicht.

Erneuerbare Energien stellen besondere Ansprüche an das Stromnetz, weil ihre Produktion schwer vorhersagbar ist und von den Launen des Wetters abhängt. Sie sind von der Regelungsseite daher wie Verbraucher zu betrachten. Für ihre gesamte Leistung ist Regelleistung notwendig. In der Dunkelflaute im Winter (ca. 3 Monate) steht bei Windstille und Hochnebel weder Solarenergie noch Windenergie zur Verfügung, so daß diese gesamte Leistung konventionell bereit gestellt werden muß. Zudem ist das die Zeit des höchsten Energieverbrauches im Jahr. Man benötigt daher für die erneuerbaren Energien den doppelten Kraftwerktspark, so daß die Produktionskosten entsprechend steigen, weil auch die Bereitstellung von Energie kostet.

Die dritte Abbildung zeigt die Stromproduktion in 2019. Gut zu erkennen ist die höhere Solarproduktion im Sommer mit wenig Windenergie und die hohe Windenergieproduktion im Winter bei geringer Solarleistung. Bei starken Stürmen wird so viel Energie produziert, die in Deutschland nicht verbraucht werden kann. Zeitweise werden Leistungen von 15 Kernkraftwerken ins Ausland abgegeben, teilweise sogar mit negativen Preisen, um das Netz aufrecht zu erhalten, d.h., der Abnehmer bekommt Geld für die Abnahme des Stromes. Aufgrund der geringeren Windleistung im Sommer wird Deutschland zum Stromimporteur gerade in den Morgen- und Abendstunden oder bei schlechtem Wetter.

In Deutschland sind inzwischen soviel Wind- und Solarenergiekraftwerke in ihrer Maximalleistung zugebaut, wie unser Stromnetz an Leistung benötigt. Dabei beträgt die durchschnittliche Nutzung ca. 20% bis 25% der installierten Maximalleistung, weil Sonne und Wind über das Jahr nicht immer zur Verfügung stehen. Wird mehr als die benötigte Maximalleistung zugebaut, besteht für diese keine Regelleistung mehr, so daß die Anlagen dann im Notfall abgeschaltet werden müssen. Ihre Wirtschaftlichkeit sinkt daher dann weiter.

Wasserkraft gibt es in Deutschland schon sehr lange. Im wesentlichen ist das Potential schon ausgeschöpft aufgrund der vorhandenen geographischen Lage. Wasserkraftwerke spielen eine wesentliche Rolle beim Hochfahren eines Stromnetzes, weil Großkraftwerke wie Kohlekraftwerke, Gaskraftwerke, Kernkraftwerke Strom für den Start benötigen.

Bildquelle: Frauenhofer Institut mit freundlicher Genehmigung.

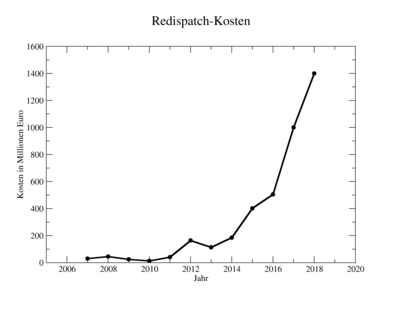

Der Redispatch bezeichnet ein Verfahren des Netzbetreibers, bei dem er in die Stromproduktion anweisend eingreift, um Leitungen vor Überlast zu schützen oder den Zusammenbruch des Netzes zu vermeiden. Unter normalen Bedingungen regelt sich das Netz weitestgehend selbst. Kommt es aber z.B. bei bestimmten Leitungen aufgrund stark schwankender Leistungen z.B. von den erneuerbaren Energien zu überhöhten Belastungen, kann eine Leitung durchglühen. Um das zu vermeiden, weist der Netzbetreiber ein Kraftwerk an, weniger zu produzieren und ein anderes auf der anderen Seite der Leitung mehr zu produzieren. Die Verluste und zusätzlichen Kosten werden extra vergütet. Diese Kosten beliefen sich vor 2012 auf unter 50 Millionen Euro pro Jahr. Aufgrund der Energiewende stiegen sie 2018 in Deutschland auf 1,4 Milliarden Euro und sind weiter steigend. Die Kosten trägt der Endverbraucher.

Die rechte Abbildung der Stromproduktion im Dezember 2019 vom Frauenhofer Institut zeigt, wie stark z.B. die Windproduktion schankt, je nachdem, wie gerade Winterstürme über das Land ziehen. In der Dunkelflaute bei Windstille und Hochnebel sinkt der Anteil der erneuerbaren Energien auf einen kleinen Anteil. Die notwendige Leistung muß dann aus konventioneller Technik kommen.

Die Anzahl Netzeingriffe ist umgekehrt

proportional auch ein Maß für die Sicherheit des

Netzes und der Stromversorgung.

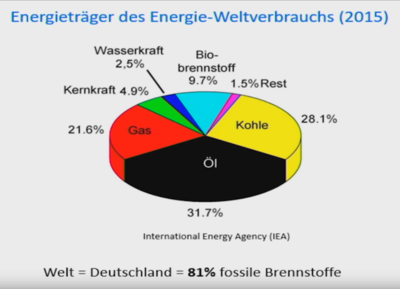

Noch heute werden etwa 80% fossile Energieträger weltweit eingesetzt. Nur 1,5% machten in 2015 Solar- und Windenergie aus. In Deutschland ist dieser Anteil auf 4% der gesamten Primärenergie angestiegen. Für diese 4% erneuerbare Energien zahlt die Bundesregierung über 20 Milliarden Euro Kompensation (Einspeisevergütung) jährlich und ist aufgrund der Einspeisevergütung dazu verpflichtet auf weitere 15 bis 20 Jahre. Pro Kopf sind das jährlich etwa 250€ oder etwa 500€ pro Haushalt. Auf 20 Jahre gerechnet, werden die deutschen Haushalte so um 10.000€ erleichtert. Der Gesamtschaden beläuft sich auf 400 Milliarden Euro, um 4% Primärenergie einzusparen. Wirtschaftlich ist dies Unsinn. Diese Geldressourcen wären sinnvoller in zukünftige Technologien investiert, die die zu neige gehenden fossilen Energieträger komplett ersetzen können. Sinnvoll wäre auch der Ausbau eines flächendeckenden Transrapid-Netzes, um den Inlandsflugverkehr oder den ins benachbarte Ausland komplett ersetzen zu können. Dieser ökologische Beitrag wäre viel wirksamer.

An der dritten Graphik wird deutlich, wie gering die Leistungsdichten der erneuerbaren Energien sind. Sie benötigen einen riesigen Flächenbedarf, der zu Lasten der Umwelt geht. Dazu eine kleine Rechnung:

Der Primärenergieverbrauch Deutschlands betrug 2017 etwa 13.594 Penta Joule (1 J = 1 W·s, eine Wattsekunde), oder 1,3594·1019 J. Die Landesfläche Deutschlands beträgt 357.582.000.000 m². Wir benötigen daher eine Leistungsdichte von 1,206 W/m² ganzjährlich auf jedem Quadratmeter des Landes.

Wie die dritte Graphik veranschaulicht, reicht die Energiedichte von Energiemais nicht für die Versorgung aus. Bei der Windenergie müßte das ganze Land mit mit einer Windkraftanlage pro km² bebaut sein, die je eine Leistung von 8 MW hat und bei der man 16% Auslastung annimmt. Dabei wird zwar die benötigte Energie produziert, sie ist jedoch nicht gleichmäßig verfügbar. Energiemengen in dieser Größenordnung sind bisher nicht speicherbar. Aufgrund der geringen Energiedichte von chemischen Bindungen, ist das in Zukunft auch nicht zu erwarten. Das Element Lithium ist mit 1,8 kg/Mensch begrenzt und reicht bei weitem nicht für Batteriespeicher dieser Größenordnung aus. Aufgrund langer Flauten im Sommer, müßte die Windenergie über Monate gespeichert werden. Dafür würden sehr große Materialmengen und Flächen benötigt werden. Wie bei Lithiumbatterien zu beobachten ist, so sind Batteriesysteme mit sehr hohen Energiedichten inherent unsicher (siehe brennender Tesla) und im Katastrophenfall unbeherrschbar. Solarenergie würde immerhin 15-20% unserer Landesfläche benötigen und hat genau das gleiche Speicherproblem wie Wind, da im Winter die Solarleistung aufgrund schlechten Wetters und insbesondere des niedrigen Sonnenstandes zu gering ist. Auch hier müßte Energie über Monate gespeichert werden.

Technologisch kommt man hier an die Grenzen der Machbarkeit. Die erneuerbaren Energien bieten nicht das Potential, die fossilen Energieträger vollständig zu ersetzen. Sie würden zudem für erhebliche ökologische Probleme sorgen.

Die Lösung liegt hingegen in der Kernenergie oder Kernfusion. Die gesamte Primärenergie Deutschlands könnte mit etwa 143 Dual-Fluid-Reaktoren erzeugt werden, die aus je 3 GW thermischer Leistung je 1 GW elektrische Leistung produzieren. Die Investitionskosten betrügen etwa 150-160 Milliarden Euro, wobei auf die fossilen Energieträger verzichtet werden könnte. Das ist weniger als die Hälfte als für die 4% der erneuerbaren Energien investiert wurde und werden wird. Das Land hätte eine autonome Energieversorgung mit den weltweit niedrigsten Preisen um 1¢/kWh. Zusätzlich würden die langlebigen radioaktiven Abfälle der alten Kraftwerke in kurzlebige Abfälle umgewandelt werden, die mit guter Vorhersagekraft sicher für 300 Jahre gelagert werden könnten.

Die linke Graphik zeigt die Leistungskurve eines Windrads in Abhängigkeit von der Windgeschwindigkeit. Die nutzbare Energie im Wind folgt dem v³-Gesetz, d.h., die Leistung nimmt mit der 3. Potenz der Windgeschwindigkeit zu. Oberhalb der Nennleistung muß die Anlage heruntergeregelt werden (flacher Kurvenverlauf). Ab Maximalwindstärke muß sie abgeschaltet werden (etwa 100 km/h, Sturm). Die Nennleistung wird auf das Jahr gerechnet aufgrund der wechselnden Windverhältnisse nicht erreicht. Durchschnittlich erreicht ein Windrad über das Jahr nur etwa 16% seiner Nennleistung (grüne Fläche).

Der Erntefaktor beschreibt die für eine Produktionsanlage aufgewendete Energie und aus ihr erhaltene Energie. Sonne, Wind und Energiemais liegen nur unwesentlich über der aufgewendeten Energie, bleiben jedoch unterhalb der Wirtschaftlichkeitsschwelle von etwa Faktor 7.

Für die Stromsicherheit ist es wichtig, ausreichend Reserveleistung zur Verfügung zu haben (Überdeckung), um bei einem gestiegenen Bedarf nachregeln zu können. Fehlt diese Reserveleistung, kann das Stromnetz nicht aufrecht erhalten werden und es kommt dann zu Stromausfällen. Ab 2020 wird es zur Unterdeckung kommen und die Reserve muß aus dem europäischen Verbundnetz kommen. Wenn 2021 und 2022 die letzten Kernkraftwerke von Netz gehen, wird das Land mit 8 GW unterdeckt sein. Falls der Vorschlag der Kohlekommision umgesetzt wird, auch die Kohlekraftwerke von Netz zu nehmen, fehlen in Deutschland rund 30 GW Leistung, die auch Regelleistung ist. Das ist etwa der halbe Gesamtbedarf.

Erneuerbare Energien sind aufgrund der Fluktuation in der Produktion nicht grundlastfähig. Eine stabiles Stromnetz ist mit ihnen nicht möglich.

Die notwendige Speichertechnologie ist extrem teuer. Hierzu eine Rechnung:

Wenn bei einem Jahresverbrauch von 3500 kWh für 4 Wintermonate Strom gespeichert werden soll und ein 12 kWh-Speicher heute etwa 7.000€ kostet, dann benötigt man etwa 97 Einheiten, die zusammen 680.555€ kosten. Batteriespeicher können etwa 15 Jahre genutzt werden (Alterungseffekte), so belaufen sich die Speicherkosten auf etwa 45.370€/Jahr, was das durchschnittliche Jahreseinkommen übersteigt. Der Strompreis würde dann bei etwa 13,00€/kWh liegen.

Dazu eine Gegenrechung:

Für 3500 kWh zahlt man heute etwa 1050€. In Ungarn zahlt man dafür heute 385€. Mit dem Dual-Fluid-Reaktor würde man stattdessen nur 35€ bezahlen und die Umwelt schonen.